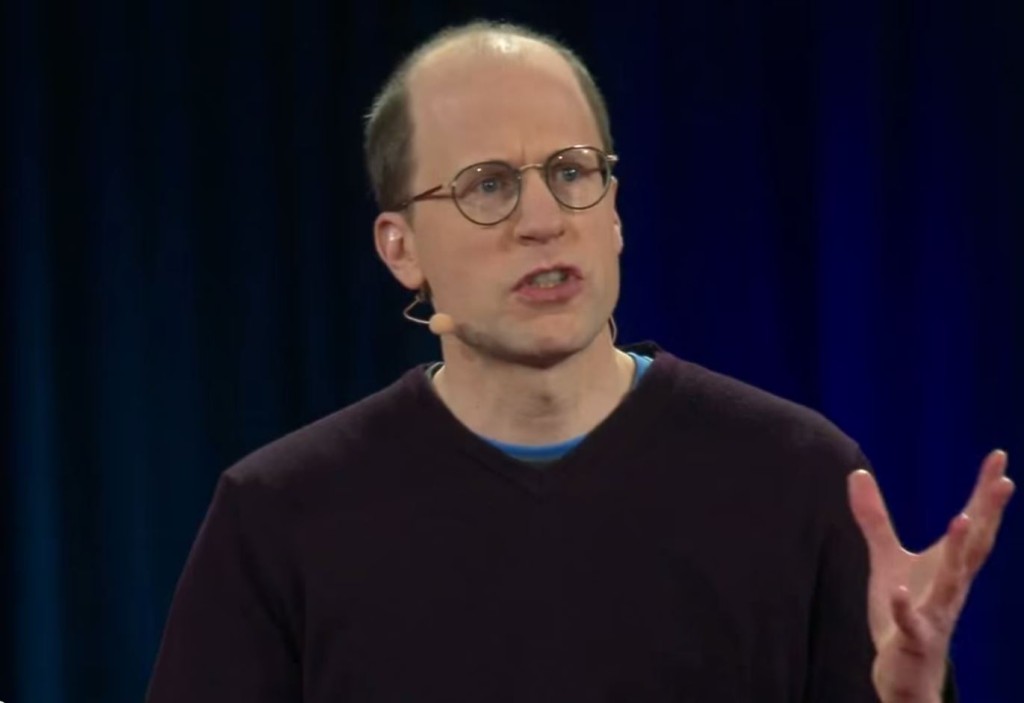

Nick

Bostrom es un filósofo sueco, profe-sor de la Universidad de Oxford,

y director del Instituto del Futuro de la Humani-dad, que se ha

desta-cado por trastocar los límites de lo que se entiende por

existen-cia humana. Sus disertaciones son fuertes y arriesgadas, cosa

extraña en el mundo académico.

Algunos

de los temas que han puesto a este filósofo de 44 años en la palestra son sus

trabajos en torno a temas como el 'principio antrópico', 'el

riesgo existencial', 'los riesgos de la superinteligencia', 'el

consecuencialismo' y 'la tecnología futurista'. Con

algunos de éstos términos quizás estemos familiarizados,

con otros tal vez no, sin embargo procuraremos hacer un breve

repaso de uno de sus temas fundamentales: la Inteligencia

Artificial (IA).

Una de

las mayores preocupaciones de Bostrom son los avances y las

implicaciones de la IA. Pues aunque la

irrupción de tales avance signifiquen beneficios para

la humanidad en áreas como la producción industrial,

la salud, la exploración espacial, la comprensión científica

y muchos otros, podría traer consigo problemas de

seguridad, dislocaciones en el mercado de trabajo, así como el

mal uso y posibles accidentes.

Pero

los riesgos son mayores aún, pues no deja de

preocu-par la socialización de dichos beneficios; se sabe bien que estos procesos, son profundamente elitistas y usureros.

Imaginemos

la aplicación de la Inteligencia Artificial (o superinteligencia),

por modesta que sea, tomando decisiones en ámbitos, además de los

ya citados (salud, industria, ciencia, educación, etc), en

temas aún más delicados como el militar y el gobierno. Bostrom

advierte en este sentido:

“En vista de lo mucho que podría estar en juego, por modesta que sea, la IA que se está desarrollando para las próximas décadas, ofrece razones suficientes para realizar un examen cuidadoso”.

Con

estas posibilidades técnicas, afirma Bostrom, “la probabilidad de

que vivamos en una simulación es alta. Pensemos en que si nuestros

parientes del futuro deciden hacer una única simulación, nuestra

probabilidad de vivir en ella es de un 50% (o somos la civilización

que en el futuro producirá la simulación o somos la simulación

misma)...”

Y

lo que sigue, es muy interesante: “...pero si nuestros parientes

deciden hacer más de una (simulación), las probabilidades de ser

una civilización real van bajando: 1/3, 1/4, 1/5… Si decidieran

hacer un ‘laboratorio de simulaciones’, pongamos 50 mundos

virtuales, la probabilidad de ser una civilización no simulada sería

mínima (0,02%) o, con la cifra inversa que suena más contundente:

tendríamos un 99,98% de probabilidad de vivir en un mundo simulado”.

Lo

anterior plantea el argumento transhumanista de

Bostrom, sin embargo, como se vio al inicio del artículo, sus

postulados son diversos e inquietantes. Aquí

algunas de sus obras: Sesgo

antrópico: efectos de la selección de observación en la ciencia y

la filosofía (2002), Riesgo

ca-tastrófico global (2008), Mejoramiento

humano (2009), Superinteligencia:

caminos, peligros, estrategias (2014).

En

futuros artículos daremos seguimiento a este y otros autores que

tocan temas parecidos, pues además de interesantes y profundos, son

una referencia esencial para tener una perspectiva sobria y

documentada sobre el futuro.

No hay comentarios. :

Publicar un comentario